Традиционно поисковую оптимизацию делят на две большие составляющие: работа над внутренними факторами и работа над внешними факторами.

Под внутренними факторами чаще всего понимают оптимизацию самого документа, повышение его релевантности определённым поисковым запросам. Внешние факторы — это ссылки. Этим аспектам посвящено достаточно большое количество статей и докладов. Однако при таком разделении выпадает из вида одна очень важная составляющая продвижения в поисковых системах — техническая база оптимизируемого сайта. Как ни странно, это та третья сила, которая часто остаётся за кадром, но которая способна свести на нет все ваши работы по оптимизации документов и расстановке ссылок. Если релевантный и авторитетный документ недоступен индексирующему роботу, у него есть дубль, или по какой-то причине в момент обхода робота страница стала отдавать техническую информацию вместо контента, успеха не будет.

Рисунок 1 — Базис оптимизации сайта.

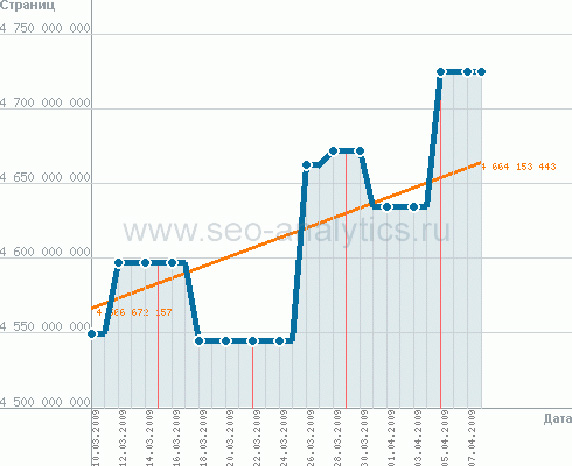

Индексная база поисковых систем растёт с невероятной скоростью (рисунок 2). Уже нет ниш, в которых был бы только один сайт. Главная задача индексирующего робота — занести в базу как можно больше документов. Именно по этой причине индексируются любые страницы, до которых робот может добраться и выкачать. Ему некогда разбираться в том, значимая ли эта страница, что в ней за контент… Уметь правильно проиндексировать сайт, направить индексирующего робота в нужное русло — первоочередная задача любого оптимизатора.

Рисунок 2 — Динамика индексной базы поисковой системы Яндекс.

Не проиндексированный или неправильно проиндексированный сайт невозможно нормально продвинуть.

В данной статье мы рассмотрим 3 основные группы технических ошибок: ошибки во вспомогательных файлах, ошибки, возникающие по причине некорректной работы CMS и технические ‘недосмотры’ оптимизатора.

Ошибки во вспомогательных файлах

К вспомогательным файлам относятся файлы robots.txt и sitemap.xml. Первый отвечает за то, как будут обходить сайт индексирующие роботы различных поисковых систем.

Sitemap.xml — это карта сайта, файл, который содержит полный список страниц сайта. С его помощью можно передать индексирующему роботу поисковой системы перечень адресов, которые надо про- или переиндексировать в первую очередь.

Robots.txt

Robots.txt — очень полезный инструмент, предоставляющий вебмастеру возможность точно определять, какие адреса должны быть проиндексированы роботами различных поисковых систем, как часто можно обращаться к страницам и т.д. Количество настроек, которые можно регулировать путём использования robots.txt постоянно растёт. Так, например, 28 января поисковой системой Яндекс be1.ru, вкладка Header.

Ошибки в .htaccess

Файл htaccess является файлом конфигурации сервера. В частности средствами этого файла определяется, как сайт будет открываться: с www перед доменным именем или без указания этой папки. Часто встречается ситуация, когда после переноса сайта на новую CMS, в htaccess указывается, что сайт, например, должен открываться только с www. При этом все адреса без www возвращают заголовок ответа сервера 301, а главным зеркалом в поисковой системе Яндекс является домен без www. В результате все проиндексированные документы с сайта будут исключены из индекса поисковой системы, а новые не будут проиндексированы, так как принадлежат второстепенному зеркалу. Результата удачной переклейки зеркал придётся ждать достаточно долго.

Самым лучшим вариантом настройки файла htaccess является разрешение открывать сайт как с www, так и без www.

Неверное формирование URL

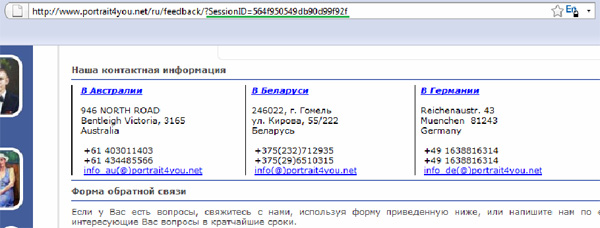

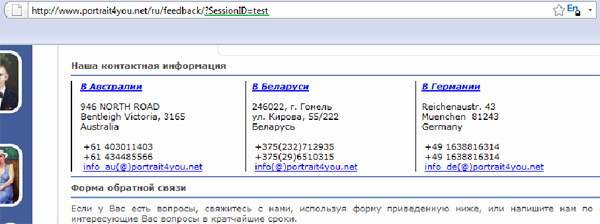

Часто встречаются CMS, которые для маркировки пользователя добавляют к url дополнительный параметр: ‘идентификатор сессии’ (рисунок 4, 5, 6). Этот маркер — частный пример параметров, из-за которых на сайтах формируется большое количество страниц с дублирующим содержимым.

Рисунок 4 — Идентификатор сессии в URL

Рисунок 5 — Случайный идентификатор сессии в URL

Рисунок 6 — Оригинальная страница, без идентификатора сессии в URL

Обратите внимание, на всех представленных выше рисунках (рисунки 4, 5, 6) приведена одна

и та же страница, но при этом она может иметь фактически бесконечное множество различных URL. А значит, для индексирующего робота каждая такая страница будет уникальной.